- 联系我们

- duidaima.com 版权声明

- 闽ICP备2020021581号

-

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

2.计算量大,最后结果数据可能就几十条,但是背后的计算量大,例如统计类数据、运营类数据

type Task struct {

ID int `json:"id"` // 任务 ID

Name string `json:"name"` // 任务名称

URL *url.URL `json:"url"` // 创建任务的 URL (也就是用于界面发起请求的 URL)

Created *time.Time `json:"created"` // 创建时间

Canceled *time.Time `json:"canceled"` // 取消时间

ExpectedRunTime *time.Time `json:"expectedRunTime"` // 预期开始时间

ExpectedFinishedTime *time.Time `json:"expectedFinishedTime"` // 预期完成时间

ActualRunTime *time.Time `json:"actualRunTime"` // 实际开始时间

ActualFinishedTime *time.Time `json:"actualFinishedTime"` // 实际完成时间

ProgressPercent float32 `json:"progressPercent"` // 任务当前进度

TimeCost float32 `json:"timeCost"` // 任务总用时

ErrorMsg string `json:"errorMsg"` // 任务错误信息

ResultFile string `json:"resultFile"` // 生成的文件下载地址

}

2. 接口type Exporter interface {

Create() *Task

Cancel(*Task)

Update(*Task)

}

下面是两个报表导出的具体实现示例:// 堆代码 duidaima.com

// OrderListExport 订单列表数据报表导出

// 限于篇幅,这里只输出代码结构作为演示

type OrderListExport struct {

...

}

func (ol *OrderListExport) Create() *Task {

...

}

// OrderStatisticExport 订单分析数据报表导出

// 限于篇幅,这里只输出代码结构作为演示

type OrderStatisticExport struct {

...

}

func (os *OrderStatisticExport) Create() *Task {

...

}

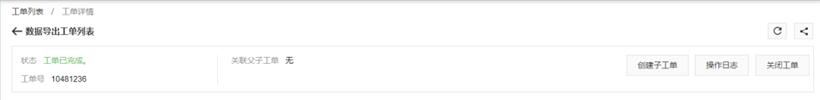

3. 创建任务

# 示例: 导出 2023 年 8 月份所有订单记录 POST https://console.example.com/orders/export?start_time=2023-08-01&end_time=2023-08-31 201 Created下面是示例请求发出之后,返回的对应数据:

{

"code": 0,

"msg":0,

"data": {

"location": {

"uri": "https://admin.duidaima.com/tasks/exports/123456"

},

"task": {

"id": 123456,

"name": "OrderList Export Test",

"created": "2023-09-17T09:26:38.084577069+08:00",

"canceled": null,

"expectedRunTime": "2023-09-17T09:27:38.084577069+08:00",

"expectedFinishedTime": "2023-09-17T09:28:38.084577069+08:00",

"actualRunTime": null,

"actualFinishedTime": null,

"progressPercent": 0,

"errorMsg": "",

"resultFile": ""

}

}

}

除了 task 字段表示的对象之外,这里还增加了一个新的对象 location, 用来表示查看已创建资源状态的链接,前端可以根据该链接增加一些交互功能, 例如在用户创建导出任务之后,给出对应的弹窗提示并引导用户点击跳转到具体任务的详情页面。最后得到是就是一个比较宽裕的任务预计完成用时

指定缓冲百分比常数为 1.2, 任务预计完成用时 = 48 * 1.2 = 57.6 秒

退货率

P = floor (100 / N)转换成对应的伪代码如下:

N := 20

P := math.Floor(float64(100 / N))

for _, subTask := range subTasks {

// 执行数据查询逻辑

...

// 执行追加写入文件逻辑

...

subTask.ProgressPercent += P

export.Update(subTask)

}

// 任务全部完成,更新进度为 100%

subTask.ProgressPercent = 100

export.Update(subTask)

7. 计算 & 更新任务总用时