前言

苹果刚刚在全球无障碍日宣布,未来几个月将在其软件平台上推出一系列新的辅助功能,其中包括眼球追踪,该功能利用人工智能让身体残疾的人仅通过眼球就可以轻松地使用 iPhone 和 iPad。除了这个功能外,苹果还推出了一系列其他的辅助功能,让我们来一起看看吧。

眼动追踪功能

眼动追踪专为身体残疾的用户而设计,首先你需要使用前置摄像头完成设置和校准,这个过程只需要在几秒钟。然后通过设备上的 AI 机器学习,它能够更精准地识别眼球的变化。眼动追踪功能可跨 iPadOS 和 iOS 应用程序运行,不需要任何额外的其他硬件或配件。

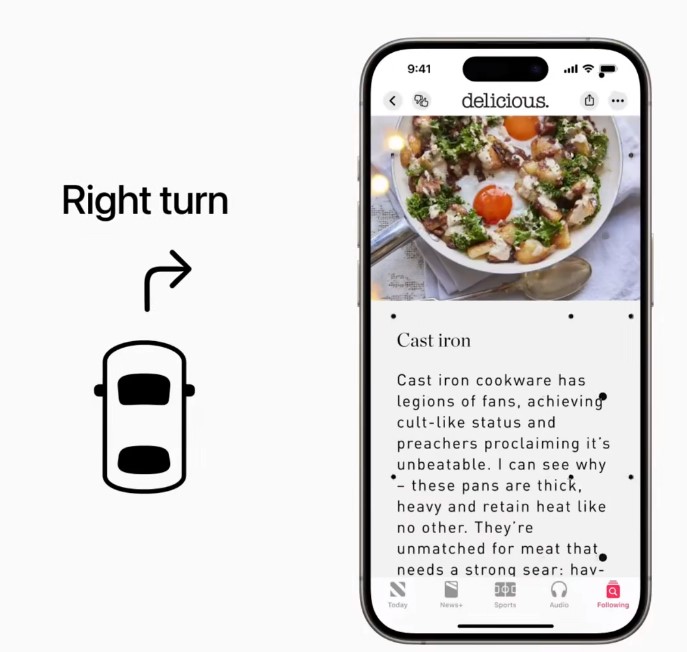

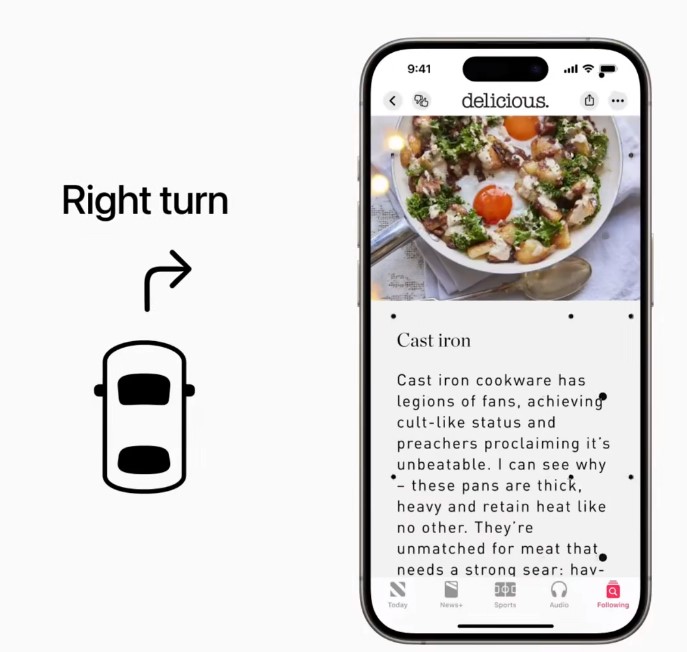

防晕车功能

有很多人在车上玩手机时容易晕车,这是由于在运动中的汽车中的人所看到的和感受到的感觉有冲突引起的,导致在行驶的汽车中很难看清屏幕,苹果推出了一个新功能可以缓解这种症状。这个功能被称为“车辆运动提示”,开启这个功能后,手机上会出现一些点,当汽车运动时,这些点也会随之变化,从而来减少感官冲突。比如,汽车向左转,这些点就会向右移动,汽车向右转,这些点就会向左移动,当汽车向前加速时,它们会向下移动,当汽车刹车时,它们会缓慢地向前移动并停下来。

这个功能对于坐车玩手机晕车的人来说相当友好。

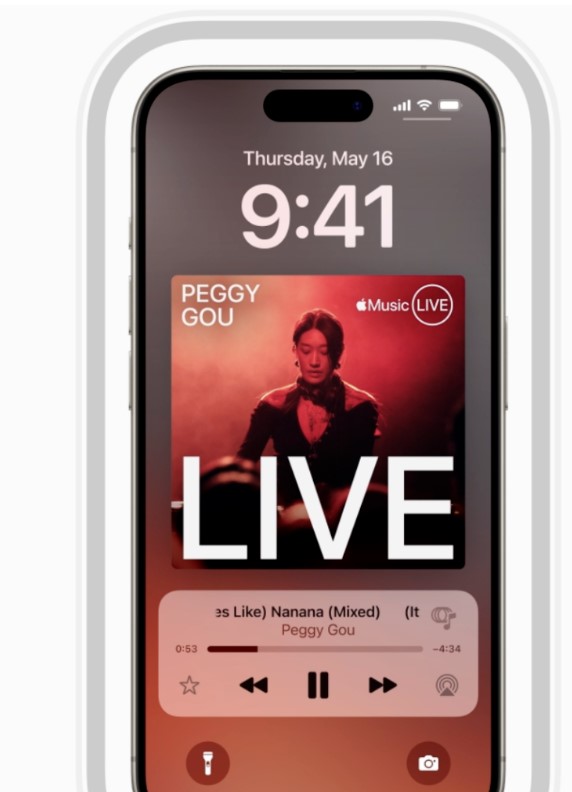

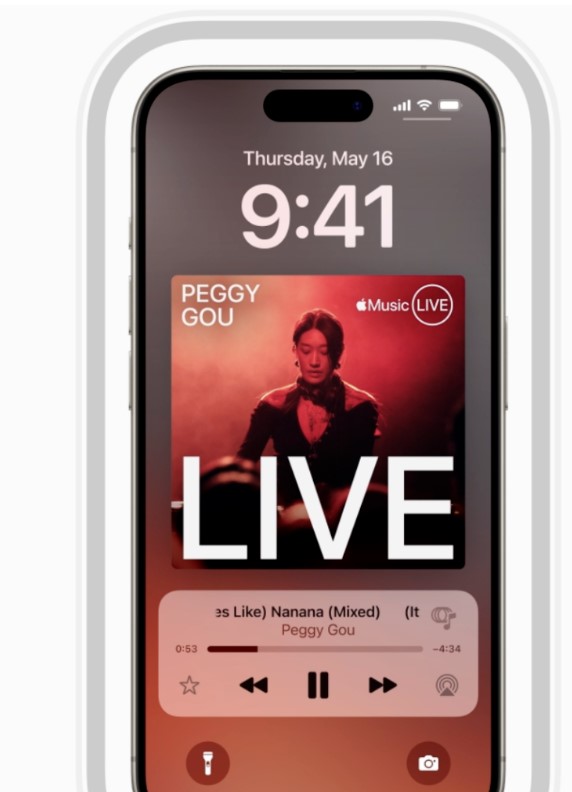

音乐触觉

音乐触觉

本次推出的 Taptic Engine 功能可以让聋哑人、听力障碍人士感受音乐,启用这个辅助功能后,iPhone 会根据音乐播放敲击声、纹理进行振动。Apple Music 中的数百万首歌曲都支持 Music Haptics,并且这项功能的 API 也将提供给开发人员。

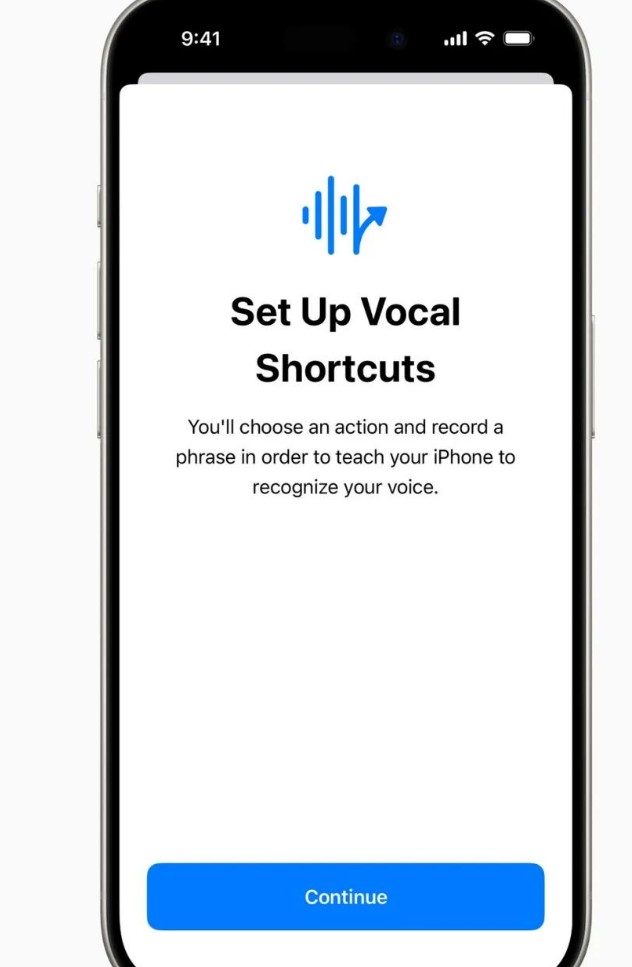

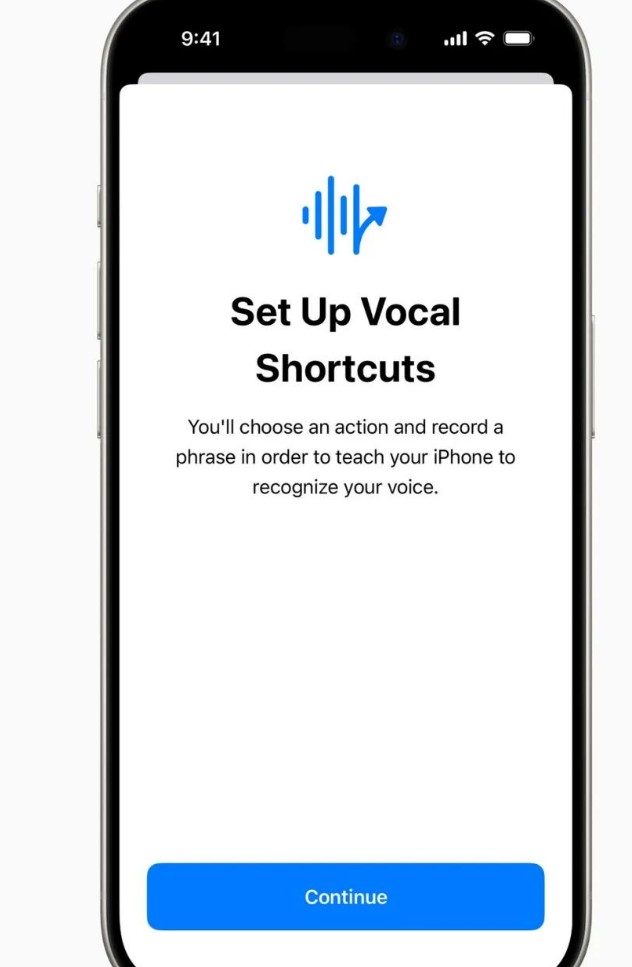

Siri 自定义短语

Siri 自定义短语

Siri 将有一个新功能,类似一种语音快捷方式,这个功能开启后,iPhone 和 iPad 用户可以让 Siri 理解自定义话语,然后启动快捷方式完成复杂的任务。这项功能主要服务于患有影响言语的疾病(例如脑瘫、肌萎缩侧索硬化症 (ALS) 或中风),这部分群体通常无法清晰说话,苹果利用人工智能改善数以百万计患者的语音识别能力。

值得注意的是,该项目由伊利诺伊大学厄巴纳-香槟分校牵头,并得到了苹果、亚马逊、谷歌、Meta 和微软等公司的支持,目标是提高残疾人的语音识别能力。

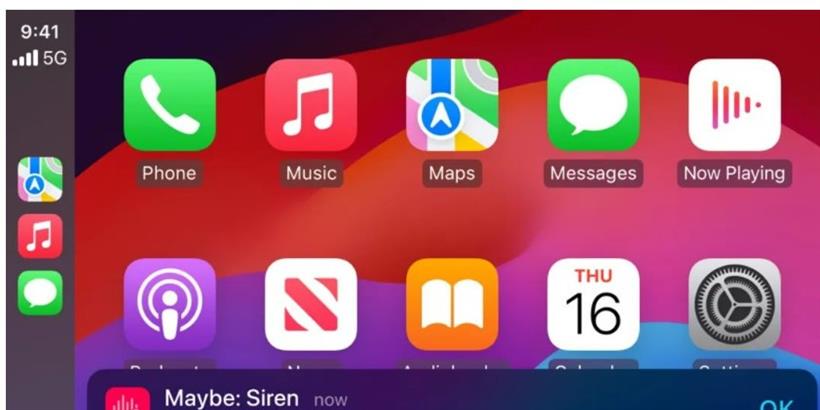

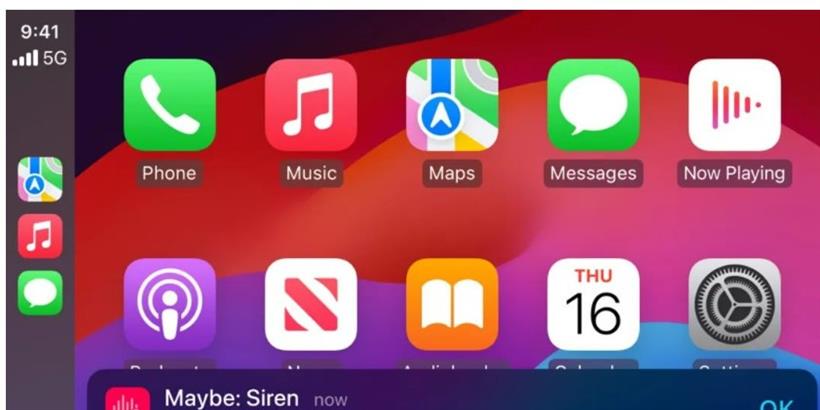

CarPlay 新功能

本次 CarPlay 的辅助功能包括语音控制、滤色镜和声音识别。借助语音控制,用户只需使用语音即可控制 CarPlay。借助声音识别功能,失聪或听力有障碍的驾驶员或乘客可以打开警报,以收到汽车喇叭和警报器的通知。对于色盲用户来说,彩色滤光片、粗体文本等使 CarPlay 界面在视觉上更易于使用。

其他更新

其他更新

除了以上大功能,苹果本次还提供了很多额外更新,包括:

1.对于盲人或视力不佳的用户,VoiceOver 有新的语音功能,自定义音量控制等。

2.放大镜将提供新的阅读器模式以及使用操作按钮轻松启动检测模式的选项。

3.盲文用户将获得一种新的方式来启动并停留在盲文屏幕输入中,以实现更快的控制和文本编辑;盲文屏幕输入可使用日语;支持 Dot Pad 多行盲文;以及选择不同输入和输出表的选项。

4.对于视力不佳的用户,在文本字段中输入内容时,悬停输入会显示更大的文本。

5.个人语音将提供普通话版本。

6.对于身体残疾的用户,AssistiveTouch 虚拟触控板允许用户使用屏幕的一小部分区域作为可调整大小的触控板来控制设备。

7.开关控制支持使用摄像头识别手指点击手势。

什么时候能体验到这些功能?

上边介绍这些功能将在几个月内登陆苹果系统,预计是在 6 月的 WWDC 24 之后,同步 iOS 18 一起推出。上边很多功能用到了人工智能和机器学习,进一步证实了 iOS 18、iPadOS 18 和其他苹果平台将大量采用人工智能功能。

最后

不得不说,苹果的设备真的是照顾到所有人的,每年都会在无障碍方面取得新突破。

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号