昨天,Nvidia 展示了其最新的 Blackwell GPU 架构。作为备受关注的 AI 芯片领域巨头 Hopper 平台的后续版本,Blackwell 架构将使得处理大规模 AI 模型时的推理性能提高高达 30 倍,同时能源消耗降低 96%。

在近五年来首次举行的线下 GTC 活动上,这家总部位于加利福尼亚州圣克拉拉的公司于周一向外界展示了首批采用 Blackwell 架构的 GPU 设计。Nvidia 表示,这些设计搭载了六项旨在加速计算的创新技术,将助力在生成式 AI、数据处理等多个领域实现技术突破。

预计这些新设计将在今年晚些时候发布,具体时间尚未公布。预计会提供基于 Blackwell 架构的云服务的供应商包括 Amazon Web Services、Microsoft Azure、Google Cloud 和 Oracle Cloud Infrastructure,以及 Lambda、CoreWeave 和 IBM Cloud 等其他公司。

在服务器市场上,Cisco Systems、Dell Technologies、Hewlett Packard Enterprise、联想和 等公司预计将推出一系列基于 Blackwell 架构的系统。支持这些 GPU 的其他原始设备制造商(OEM)包括 ASRock Rack、华硕、Eviden 和技嘉(Gigabyte)。

自从 2022 年 ChatGPT 和 Stable Diffusion 等生成式 AI 应用上线以来,Blackwell 是 Nvidia 针对数据中心 GPU 推出的首次架构更新。这一更新掀起了 AI 开发领域的新一轮高潮和投资热潮,为那些投资于相关技术的合作伙伴带来了益处。

这种热潮已经为 Nvidia 带来了丰厚的回报,其 GPU 已成为这些应用背后的模型训练和运行的核心动力。由此带来的 GPU 高需求,如 H100 及相关系统,成为 Nvidia 去年收入翻倍至 609 亿美元的主要因素,其收入甚至超过了 Intel。

Blackwell 的设计包括 B100、B200 和 GB200

首批确认采用 Blackwell 架构的设计包括 B100 和 B200 GPU,这两款 GPU 分别是基于 Hopper 的 H100 和 H200 在 x86 系统中的后续产品。预计 B200 将拥有比 B100 更大的高带宽内存容量。

首批设计还包括了 GB200 Grace Blackwell Superchip,它在一个封装中将 B200 GPU 与该公司基于 Arm 的 72 核 Grace CPU 结合起来,该 CPU 此前曾与 H200 和 H100 搭配使用。

与将单个 Grace CPU 与 Hopper GPU 结合在一起的 Grace Hopper Superchips 不同,Grace Blackwell Superchip 将单个 Grace CPU 与两个 Blackwell GPU 结合,其性能与第一代相比有了明显提升。

在处理最为苛刻的 AI 工作负载,尤其是那些结合了多个模型、参数数量超过 1 万亿的复杂大型 AI 模型(被称为 “专家混合模型”)时,Nvidia 认为 GB200 是 Blackwell 架构真正大放异彩的地方。Nvidia 表示,在一个配置有 18 个 GB200 的液冷系统中,36 个 Blackwell GPU 能够提供高达风冷系统中 64 个 H100 GPU 的 30 倍 LLM 推理性能。

虽然 Nvidia 承诺在推理性能、能源效率和成本方面取得了大幅进步,但 Blackwell 最高性能配置的能源需求也相应增加。公司表示,Blackwell 的配置范围从 700 瓦特(Hopper 的最高功率,也是风冷 HGX B100 形态的最高功率)到 1200 瓦特(GB200 在新型液冷机架架构中所需的功率) 。

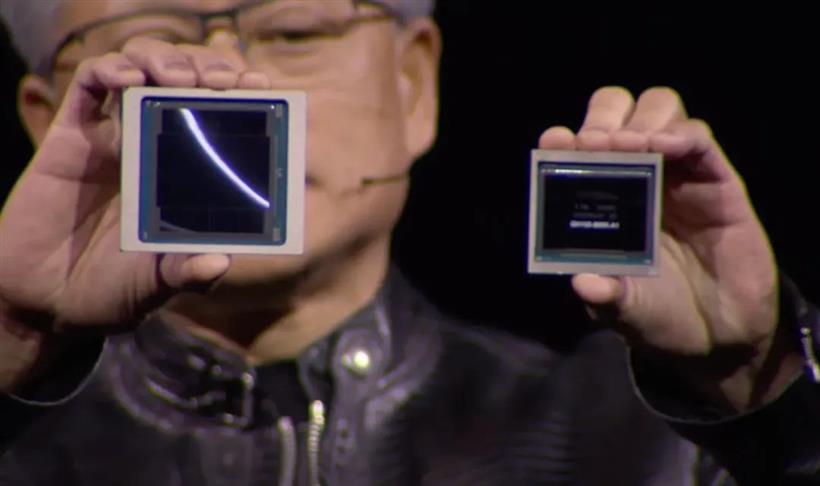

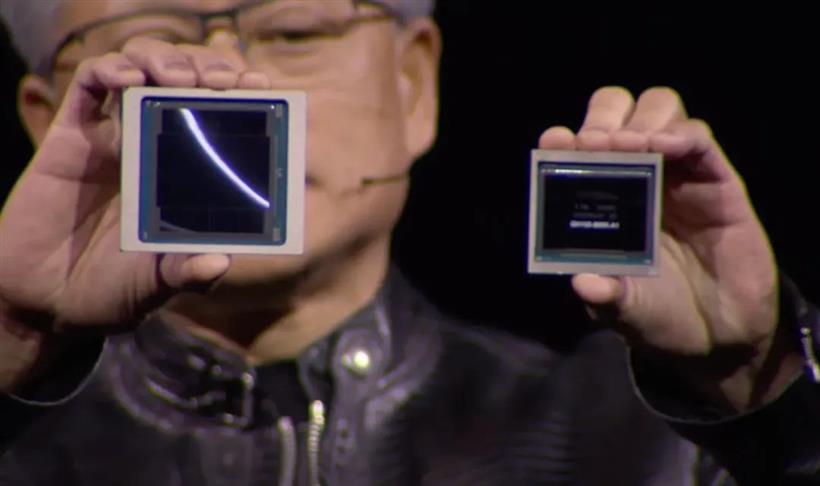

Blackwell 搭载多达 2080 亿个晶体管

Nvidia 的数据中心 GPU 设计发生了转变,Blackwell 将 “两个可能最大的芯片” 整合到一个封装中。公司指出,这些芯片通过 10 TB/s 的超高速芯片间连接技术相连,使其能够作为一个 “单一且统一的 GPU” 运行,而不会出现传统芯片组方案中的编程行为缺陷。这一创新使 GPU 的晶体管总数达到了惊人的 2080 亿个,较前代产品 H100 增加了 160%。

实现这一设计的关键在于台积电为 Nvidia 量身定制的两掩模版极限 4NP 制造工艺。Nvidia 称这是 Blackwell “革命性技术” 之一。

一位 Nvidia 的发言人在接受 CRN 采访时表示,“Blackwell 并非芯片组设计”。芯片组设计是指在一个封装中连接多个小芯片的方法,多年来这种设计一直是 AMD 的选择,例如其 Instinct MI300 数据中心 GPU,而最近英特尔也采用了这种设计,应用于其更广泛的产品线,包括 Max 系列数据中心 GPU。

第二代 Transformer 引擎助力 Blackwell 加速 AI 性能

在 AI 性能方面,Blackwell GPU 能够实现高达 20 拍的浮点运算性能,即每秒 20 万亿次计算。这一数据来自 Nvidia 超大规模和高性能计算部门副总裁 Ian Buck。这是使用一种称为四位浮点数(FP4)的新数值格式测量的,它的精度低于 Blackwell 的前代产品 Hopper 引入并用于每个 H100 提供 4 拍浮点运算的 FP8 格式。

“达到如此精细的计算级别本身就是一个奇迹,”Buck 在一次简报中表示。

这一创新得益于 Blackwell 的第二代 Transformer 引擎。该引擎最初在 Hopper 中引入,旨在加速基于 Transformer 架构的模型,这种架构在当今 AI 领域占据主导地位,比如 LLM 和扩散模型。Buck 解释称,Transformer 引擎最初设计的目的是 “追踪 GPU 中每个张量计算单元的每一层的准确性”。在 GPU 训练模型过程中,该引擎会 “不断监控每一层的数值范围,并调整以保持在数值精度的边界内,以实现最佳性能”。

作为 Blackwell “六大革命性技术” 之一,第二代 Transformer 引擎通过 “微张量缩放” 实现了更精细的监控,允许引擎查看 “张量内的单个元素”。

Nvidia 的 TensorRT-LLM 开源软件库也为 Blackwell 达到单 GPU 20 拍的浮点运算性能提供了帮助。该公司去年发布了这个库,旨在将 H100 GPU 上的 LLM 的推理性能提高一倍,同时还推出了 NeMo Megatron 框架,用于训练这些模型。

第五代 NVLink 实现 576 个 GPU 之间的高速连接

Nvidia 宣称 Blackwell 的另一项重要技术升级是第五代 NVLink 芯片间互连技术,它使 GPU 之间能够实现高速通信。新一代 NVLink 使每个 GPU 的双向吞吐量达到了 1.8 TB/s,是 Hopper 使用第四代 NVLink 实现的 900 GB/s 的两倍。此外,它还大幅提高了可以以这些速度进行通信的 GPU 数量,实现了高达 576 个 GPU 之间的 “无缝高速通信”。这比 Hopper 中 NVLink 支持的最多 256 个 GPU 有明显增加。

Buck 指出,这一升级解决了运行大规模 AI 模型的大型 GPU 集群中日渐增长的瓶颈问题,例如运行包含多个协同工作以执行复杂功能并提供更好响应的 1.8 万亿参数的专家混合模型。

“如果你运行像 GPT-4 这样的模型,它是 1.8 万亿参数的专家混合模型,你可能会花费高达 60% 的时间进行数据通信,只有 40% 的时间进行计算,”Buck 表示,这是在使用基于 Hopper 的 Nvidia GPU 的情况下的一个场景。

Blackwell 的其他升级

Blackwell 的其他主要技术升级包括:

专门的 RAS(可靠性、可用性和服务性能)引擎。这些特性通常在服务器 CPU 中发现,例如 Intel 的 Xeon 芯片。Nvidia 的 RAS 解决方案还包括芯片级的基于 AI 的预防性维护功能,旨在减少大规模部署的停机时间。

高级的保密计算功能,能够 “在不影响性能的情况下保护 AI 模型和客户数据。” 这包括对 “新的本地接口加密协议” 的支持。专门的解压缩引擎,可加速数据分析和数据科学应用程序的数据库查询,Nvidia 将其视为 GPU 的重要发展方向。

Blackwell 将助力新型 DGX 系统

Nvidia 正在推出两款搭载 Blackwell GPU 的新型 DGX 系统:

DGX B200,一款空气冷却设计,将 B200 GPU 与 x86 CPU 配对,可用于 DGX SuperPod 集群。

DGX GB200,一款液冷设计,使用 GB200 Grace Hopper GPU。八套此系统构成一个 DGX SuperPod 集群,共含 288 个 Grace CPU、576 个 B200 GPU 和 240TB 的高速内存。这使 DGX SuperPod 能够实现 11。5 拍浮点运算,即每秒 1000 亿次计算的 FP4 计算能力。

GB200 基础的 SuperPod 使用 Nvidia 与 AWS 合作推出的新版机架规模架构制造,用于支持大型生成式 AI 应用。

Nvidia 表示,它被称为 GB200 NVL72,是一个 “面向最计算密集型工作负载的多节点、液冷、机架规模系统”,包含 36 个 GB200 Grace Blackwell Superchip 以及公司的 BlueField-3 数据处理单元(DPU)。

这些 DPU 旨在 “在超大规模 AI 云中实现云网络加速、可组合存储、零信任安全和 GPU 计算弹性”,该公司表示。GB200 NVL72 系统将成为 Microsoft Azure、AWS、谷歌云和甲骨文云基础设施提供基于 Blackwell 的实例的基础,后三者将在这些系统上提供 Nvidia 的 DGX 云服务。

Nvidia 计划允许 OEM 和其他合作伙伴使用 HGX 服务器板构建自己的基于 Blackwell 的系统,该板连接八个 B100 或 B200 GPU。公司尚未宣布在标准服务器中提供 Blackwell GPU 的 PCIe 卡的计划。

两款新的高速网络平台

为了实现这些系统之间的高带宽连接,Nvidia 宣布了两款新的高速网络平台,提供高达 800 GB/s 的速度:Quantum-X800 InfiniBand 平台和 Spectrum-X800 以太网平台。Nvidia 表示,Quantum-X800 包括 Quantum 3400 交换机和 ConnectX-8 SuperNIC,可提供五倍的带宽容量,并为网络内计算提供了九倍的增长,达到 14.4 拍浮点运算。

另一方面,Spectrum-X800 “优化了网络性能,有助于加快 AI 工作负载的处理、分析和执行”,据 Nvidia 称。公司表示,这将加快 “AI 解决方案的开发、部署和上市时间”。

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号