朋友们,你想不想要那种随时随地、无需等待、并且绝对安全的贴身智能。芯片界的大佬Arm扔出了一颗重磅炸弹,正式发布了名为Arm Lumex CSS的新一代移动芯片设计。一句话概括它的威力:让你的手机、你的电脑,在断网状态下,也能流畅运行那些曾经只能在云端服务器上跑的AI大模型。

AI不上云,直接在你手里狂飙

AI不上云,直接在你手里狂飙

过去,我们总以为AI是个“大家伙”,得养在千里之外的数据中心里。我们的手机只是个“传话筒”,把需求发过去,再眼巴巴地等着云端老大给回复。这套玩法有三大硬伤:延迟、隐私和成本。你所有的数据要漂洋过海走一遭,一来一回,费网费电;更别提你的照片、语音这些私密数据,全在云上“裸奔”。

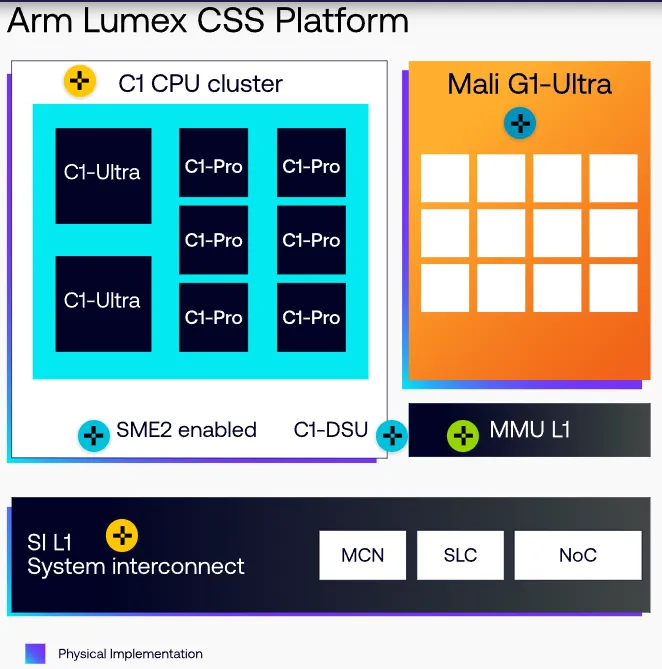

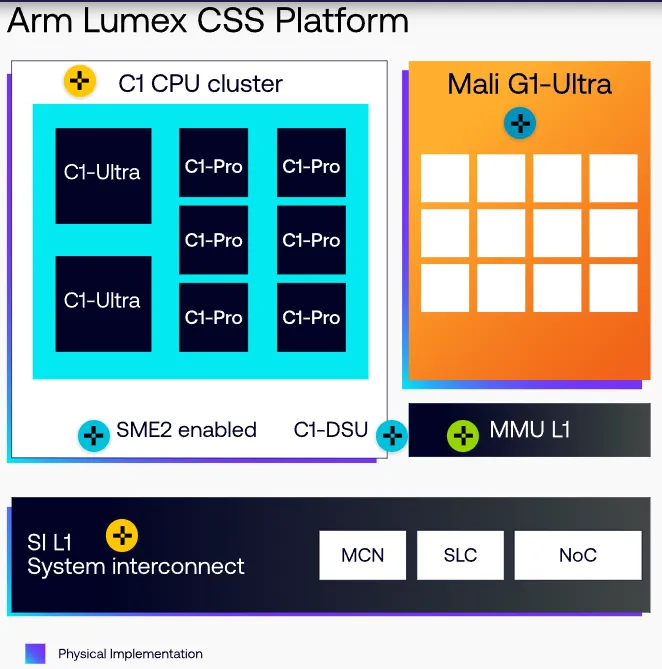

Arm Lumex平台的核心思想就六个字:“设备端AI (On-Device AI)”。就是把AI的计算能力,从遥远的云端,直接拽回到你的设备里。为了实现这个目标,Lumex平台从里到外都为AI进行了脱胎换骨的优化,它集成了Arm家最顶级的CPU 、GPU和系统IP (知识产权核)。

Arm高级副总裁兼终端事业部总经理Chris Bergey是这么说的:“AI已不再仅仅是一项技术功能,它已成为下一代移动与消费技术的支撑底座。依托Arm Lumex平台,我们持续提升端侧AI体验,以满足用户日益增长的需求与期待。” 翻译一下就是:以后别把AI当App了,它就是你设备的基础能力,像呼吸一样自然。

Arm还画了个大饼,但这个饼看起来格外香:预计到2030年,一项名为SME (可伸缩矩阵扩展) 的关键技术,将为超过30亿台设备,凭空增加超过100亿TOPS (每秒万亿次运算) 的AI算力。这意味着,未来的智能手机、笔记本,甚至你的智能手表,都能在本地处理复杂的AI任务。无论是聊天机器人、实时P图,还是懂你心意的个性化推荐,一切都在你的设备上瞬间完成,跟云端服务器彻底说拜拜。

掀桌子的黑科技:SME2到底有多猛

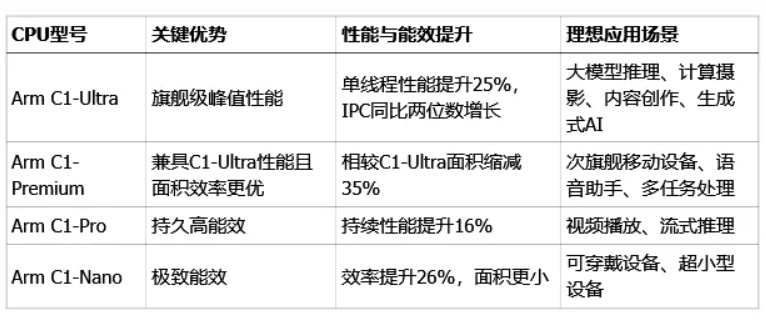

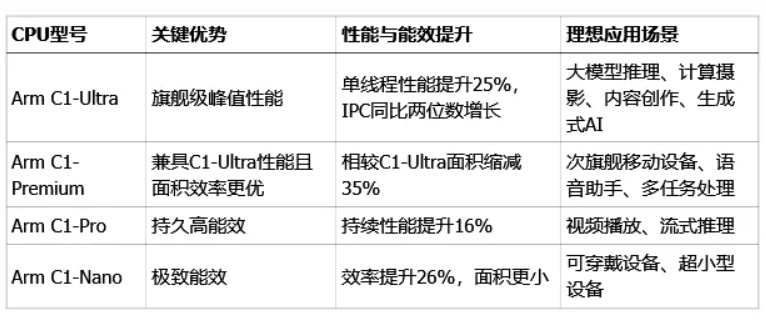

要让AI在小小的手机芯片上跑起来,光喊口号是没用的,得有真功夫。Lumex平台的杀手锏,就是首次在移动端全面引入的第二代可伸缩矩阵扩展技术 (Scalable Matrix Extension 2,简称SME2)。你可以把它理解为给CPU装上了一个专门为AI计算定制的“超级加速器”。这个加速器被集成在了全新的Armv9.3架构C1系列CPU集群里。这个C1家族有四个兄弟,分工明确,从顶级旗舰到微型穿戴设备,总有一款适合你:

表:Arm Lumex CSS平台C1系列CPU参数对比(数据来源:Arm官方新闻稿、EDN China)

有了SME2技术加持,C1系列CPU在处理AI任务时简直像开了挂,官方数据听着都有点吓人:

1.AI性能直接起飞,最高能提升到恐怖的5倍。

2.实时语音识别、翻译这类场景,延迟直接降低4.7倍,几乎是说到哪翻译到哪。

3.AI生成音乐、合成语音的速度,也快了2.8倍。

这些数字可不是PPT上吹牛。Arm现场演示了一个“智能瑜伽教练”应用,有了SME2,文字转语音 (TTS) 的速度快了2.4倍,教练的指导和反馈几乎是即时的,而且全程不怎么耗电。更接地气的例子来自Arm、支付宝和vivo的三方合作,他们在新一代旗舰手机上跑大语言模型,交互响应时间缩短了整整40%。这意味着你跟手机AI聊天,再也不会有那种“对方正在输入...”的尴尬停顿了。

SME2的厉害之处还不止于快。它甚至能干一些以前CPU想都不敢想的活儿。比如,只用一个CPU核心,就能在1080P分辨率下实现超过120fps的视频降噪,或者在4K分辨率下达到30fps。翻译过来就是,以后你在KTV那种昏暗灯光下拍照录像,手机也能给你拍出白天的清晰感,噪点?不存在的。

不止CPU,连GPU都一起卷起来了

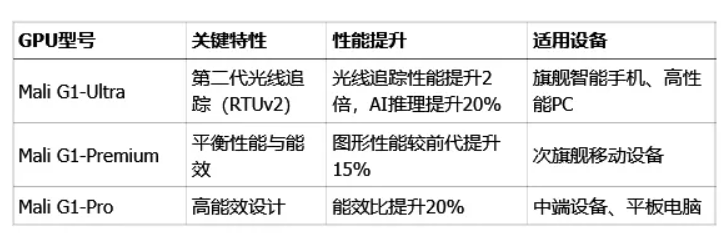

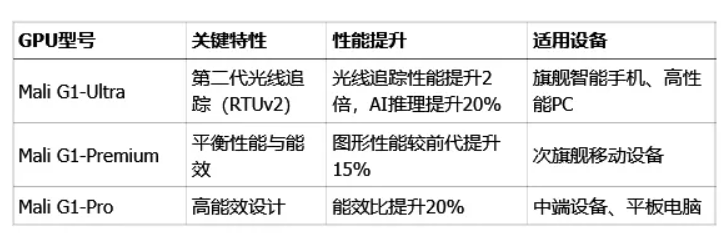

在AI这条路上,CPU在狂奔,GPU也没闲着。Lumex CSS平台里全新的Arm Mali G1-Ultra GPU,不仅让手游画质向主机看齐,自己也悄悄加装了AI加速单元,成了CPU的好帮手。这款GPU搭载了第二代光线追踪单元 (Ray Tracing Unit v2),光追性能直接翻倍。这意味着手机上的光影、反射效果会变得无比真实,玩游戏就像看电影大片。在《暗区突围:无限》、《堡垒之夜》、《原神》、《崩坏:星穹铁道》这些热门游戏里,性能提升是全方位的。同时,在AI推理任务上,它也能贡献最高20%的性能提升,让各种实时应用反应更快。

当然,Arm也考虑到了不同定位的设备,一同推出了Mali G1-Premium和Mali G1-Pro,主打一个均衡和高能效。

表:Arm Mali G1系列GPU参数对比(数据来源:Arm官方新闻稿、EDN China)

大佬排队点赞,生态圈已经安排上了

再牛的硬件,没有软件生态支持也是白搭。Arm显然深谙此道,他们推出了一个名为KleidiAI的软件库。这玩意儿就像一个“万能插座”,已经悄悄集成到了我们熟悉的所有主流手机系统和AI框架里,比如PyTorch ExecuTorch、Google LiteRT、阿里巴巴MNN以及微软ONNX Runtime。最骚的操作是,开发者用起来几乎是“零成本”。他们不需要为了SME2去改一行代码,KleidiAI会自动把硬件的洪荒之力引导到App里。这意味着,无论是Google家的Gmail、YouTube,还是支付宝的大模型应用,只要手机用了Lumex平台,一开机就能享受到丝滑的AI加速。

这种“硬件搭台,软件唱戏”的模式,引来了全球科技巨头的一致好评,纷纷发来“贺电”:阿里巴巴淘天集团业务技术MNN负责人姜霄棠说:“通过深度集成与SME2,MNN现已能在智能手机端,为通义千问等十亿参数级的大模型提供低延迟的量化推理能力。”

Google安卓平台杰出软件工程师Iliyan Malchev表示:“得益于SME2技术增强的硬件,像Gemma 3这样更先进的AI模型能够直接在各类设备上运行…最终让终端用户在他们智能手机上随时享受低延迟的AI体验。”

Meta人工智能合作部总监Sy Choudhury也对KleidiAI与PyTorch的集成感到兴奋,认为这将“为终端用户带来体验的显著加速”。腾讯机器学习平台专家杨晓峰也肯定道:“SME2技术通过突破关键性能瓶颈,高效助力大语言模型在移动端落地部署,如腾讯混元大模型,为端侧大语言模型提供强劲加速。”

这豪华的“点赞”阵容,从手机厂商、操作系统巨头到应用开发商,整个产业链的核心玩家都已入局。过去,手机没网就是砖。从今往后,不管有网没网,手机都是我们的贴身小秘了。

参考资料:

https://newsroom.arm.com/news/announcing-lumex-css-platform-ai-era

https://www.ednchina.com/products/14478.html

https://www.arm.com/products/mobile/compute-subsystems/lumex

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号