- 联系我们

- duidaima.com 版权声明

- 闽ICP备2020021581号

-

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

/// <summary>

/// 使用HashSet去重

/// TODO:HashSet是一个集合类,它的特点是不允许重复元素,可以方便地实现去重功能。

/// </summary>

public static void HashSetDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

HashSet<int> uniqueData = new HashSet<int>(dataSource);

Console.WriteLine(string.Join(", ", uniqueData));

}

使用循环遍历去重 /// <summary>

/// 直接循环遍历去重

/// </summary>

public static void LoopTraversalDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

//if (!uniqueData.Any(x => x == item))

//if (!uniqueData.Exists(x => x == item))

if (!uniqueData.Contains(item))

{

uniqueData.Add(item);

}

}

Console.WriteLine(string.Join(", ", uniqueData));

}

使用Linq的Distinct()方法去重 /// <summary>

/// 堆代码 duidaima.com

/// 使用Linq的Distinct()方法去重

/// </summary>

public static void DistinctDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

var uniqueData = dataSource.Distinct().ToList();

Console.WriteLine(string.Join(", ", uniqueData));

}

使用Linq的GroupBy()方法去重 /// <summary>

/// 使用Linq的GroupBy()方法去重

/// </summary>

public static void GroupByDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

//GroupBy()方法将原始集合中的元素进行分组,根据指定的键或条件进行分组。每个分组都会有一个唯一的键,通过将原始集合分组并选择每个分组中的第一个元素,实现了去重的效果。

var uniqueData = dataSource.GroupBy(item => item).Select(group => group.First()).ToList();

Console.WriteLine(string.Join(", ", uniqueData));

}

使用自定义的比较器和循环遍历 /// <summary>

/// 使用自定义的比较器和循环遍历

/// </summary>

public static void CustomEqualityComparerDuplicate()

{

var dataSource = new List<int>() { 1, 2, 3, 2, 5, 88, 99, 99, 100, 88, 30, 50, 15, 100, 99, 99, 2, 3 };

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

if (!uniqueData.Contains(item, new CustomEqualityComparer()))

{

uniqueData.Add(item);

}

}

Console.WriteLine(string.Join(", ", uniqueData));

}

/// <summary>

/// 自定义的比较器

/// </summary>

public class CustomEqualityComparer : IEqualityComparer<int>

{

public bool Equals(int x, int y)

{

return x == y;

}

public int GetHashCode(int obj)

{

return obj.GetHashCode();

}

}

性能基准对比测试分析using BenchmarkDotNet.Attributes;

namespace BenchmarkDotNetExercise

{

[MemoryDiagnoser]//记录内存分配情况

public class DataSetDeduplicationBenchmark

{

private List<int> dataSource;

public DataSetDeduplicationBenchmark()

{

// 生成大量重复数据

dataSource = Enumerable.Repeat(Enumerable.Range(1, 100), 10000).SelectMany(x => x).ToList();

}

/// <summary>

/// 使用HashSet去重

/// TODO:HashSet是一个集合类,它的特点是不允许重复元素,可以方便地实现去重功能。

/// </summary>

[Benchmark]

public void HashSetDuplicate()

{

HashSet<int> uniqueData = new HashSet<int>(dataSource);

}

/// <summary>

/// 直接循环遍历去重

/// </summary>

[Benchmark]

public void LoopTraversalDuplicate()

{

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

//if (!uniqueData.Any(x => x == item))

//if (!uniqueData.Exists(x => x == item))

if (!uniqueData.Contains(item))

{

uniqueData.Add(item);

}

}

}

/// <summary>

/// 使用Linq的Distinct()方法去重

/// </summary>

[Benchmark]

public void DistinctDuplicate()

{

var uniqueData = dataSource.Distinct().ToList();

}

/// <summary>

/// 使用Linq的GroupBy()方法去重

/// </summary>

[Benchmark]

public void GroupByDuplicate()

{

//GroupBy()方法将原始集合中的元素进行分组,根据指定的键或条件进行分组。每个分组都会有一个唯一的键,通过将原始集合分组并选择每个分组中的第一个元素,实现了去重的效果。

var uniqueData = dataSource.GroupBy(item => item).Select(group => group.First()).ToList();

}

/// <summary>

/// 使用自定义的比较器和循环遍历

/// </summary>

[Benchmark]

public void CustomEqualityComparerDuplicate()

{

var uniqueData = new List<int>();

foreach (var item in dataSource)

{

if (!uniqueData.Contains(item, new CustomEqualityComparer()))

{

uniqueData.Add(item);

}

}

}

/// <summary>

/// 自定义的比较器

/// </summary>

public class CustomEqualityComparer : IEqualityComparer<int>

{

public bool Equals(int x, int y)

{

return x == y;

}

public int GetHashCode(int obj)

{

return obj.GetHashCode();

}

}

}

}

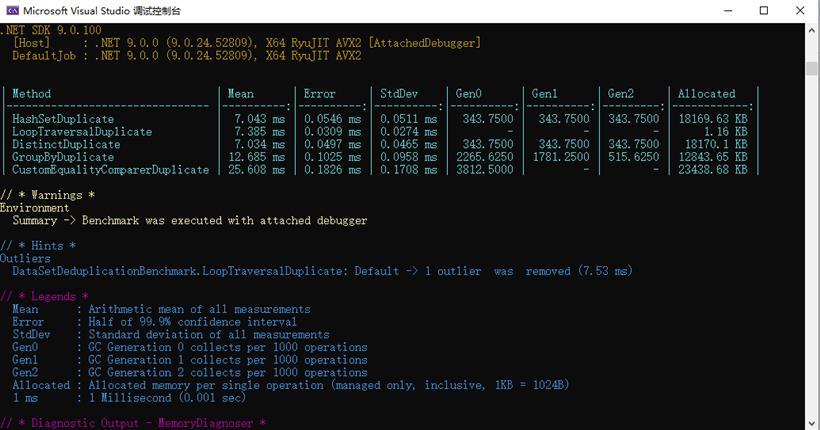

分析生成的报告

| Method | Mean | Error | StdDev | Gen0 | Gen1 | Gen2 | Allocated |

|---|---|---|---|---|---|---|---|

| HashSetDuplicate | 7.043 ms | 0.0546 ms | 0.0511 ms | 343.7500 | 343.7500 | 343.7500 | 18169.63 KB |

| LoopTraversalDuplicate | 7.385 ms | 0.0309 ms | 0.0274 ms | - | - | - | 1.16 KB |

| DistinctDuplicate | 7.034 ms | 0.0497 ms | 0.0465 ms | 343.7500 | 343.7500 | 343.7500 | 18170.1 KB |

| GroupByDuplicate | 12.685 ms | 0.1025 ms | 0.0958 ms | 2265.6250 | 1781.2500 | 515.6250 | 12843.65 KB |

| CustomEqualityComparerDuplicate | 25.608 ms | 0.1826 ms | 0.1708 ms | 3812.5000 | - | - | 23438.68 KB |