在前端开发领域,Node.js 作为 JavaScript 的服务器端运行时,已成为构建高效 Web 应用的核心工具。然而,随着 AI 和机器学习应用的兴起,许多开发者面临一个痛点:如何无缝整合 Python 的强大生态,尤其是其异步 Web 框架如 FastAPI 或 Django Channels?2025 年 10 月 7 日,Platformatic 团队发布了革命性的 @platformatic/python-node 库,它允许在 Node.js 进程内直接运行 Python ASGI(Asynchronous Server Gateway Interface)应用,而无需额外的进程或网络开销。这项技术不仅桥接了 JavaScript 和 Python 两大生态,还为混合语言开发提供了高效路径。

这一创新源于社区对跨语言互操作性的长期需求。传统方法如子进程调用或 API 桥接往往引入延迟和复杂性,而 @platformatic/python-node 通过嵌入式 Python 解释器和 Rust 桥接实现了零开销通信。这一革命性融合对于前端开发者来说,可以轻松扩展 Node.js 项目,融入 Python 的 ML 库如 TensorFlow 或 Scikit-learn,而无需重构整个后端架构。

Python ASGI介绍

ASGI(Asynchronous Server Gateway Interface,异步服务器网关接口)是 Python 生态中用于构建异步 Web 应用的接口规范,类似于传统的 WSGI(Web Server Gateway Interface),但专为异步编程设计。它是现代 Python Web 框架(如 FastAPI、Starlette 和 Django Channels)的核心,允许开发者构建支持 HTTP、WebSocket 和其他异步协议的高性能应用。

ASGI 定义了服务器(如 Uvicorn)和应用之间的通信协议。核心组件包括:

应用(Application):一个异步可调用对象,接收 scope(请求元数据,如路径、头信息)和 receive/send(异步事件处理函数)。

服务器(Server):如 Uvicorn、Hypercorn,负责处理网络请求并与 ASGI 应用交互。

协议:通过 scope 传递请求上下文,receive 获取请求数据,send 返回响应。

ASGI 与 Node.js 的融合

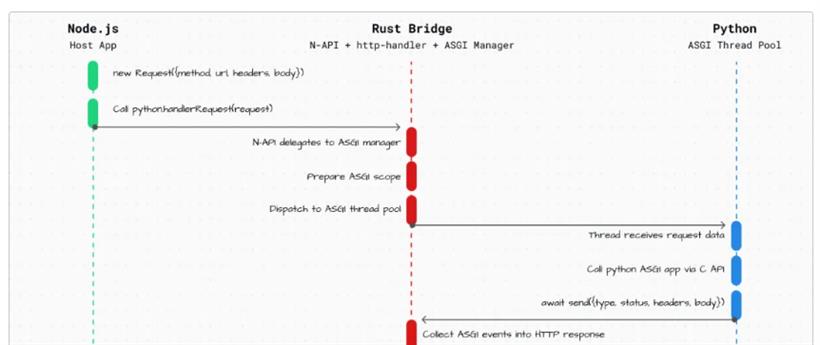

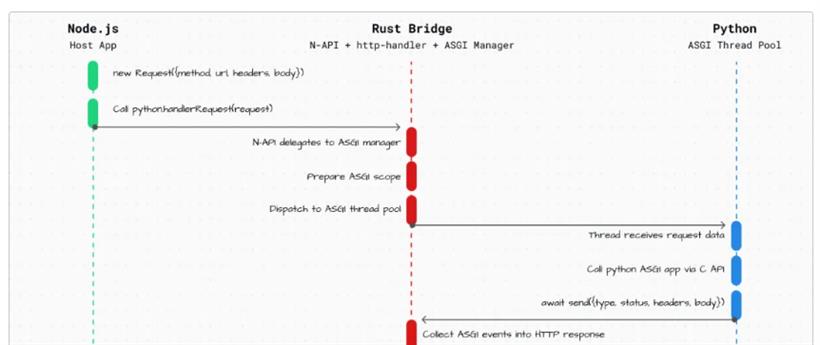

@platformatic/python-node 通过嵌入 CPython 解释器到 Node.js 进程中,实现了真正的进程内运行。 核心机制包括:

Rust 桥接层:使用 Rust 构建的高性能桥接,确保 JavaScript 和 Python 线程间的直接内存共享,避免网络或 IPC 开销。

零拷贝通信:请求和响应数据在内存中直接传递,提高吞吐量和降低延迟。

兼容性:支持标准 ASGI 应用,无需修改 Python 代码。

这一设计基于 ECMAScript 的最新规范(如 async/await)和 Node.js 的多线程能力,确保与现代前端框架(如 React 或 Vue)的集成顺畅。关键实现原理是 platformatic-python NPM 包,它在 Node.js 中启动一个 Python 运行时。安装后,你可以像加载 Express 中间件一样加载 Python ASGI 应用。

示例代码展示了如何在 Node.js 中无缝调用 Python 路由:

1.Node.js 侧(app.js):

// app.js - Node.js 侧

const { createServer } = require('node:http');

const { PythonASGI } = require('@platformatic/python-node');

asyncfunction main() {

// 加载 Python ASGI 应用

const asgiApp = await PythonASGI.load('path/to/your/asgi.py');

// 将 HTTP 请求转发到 Python ASGI

const server = createServer((req, res) => {

asgiApp.handle(req, res);

});

server.listen(3000, () => console.log('Server running on http://localhost:3000'));

}

main();

2.Python 侧(asgi.py):

# asgi.py - Python FastAPI 示例

from fastapi import FastAPI

app = FastAPI()

@app.get("/")

async def root():

return {"message": "Hello from Python in Node.js!"} # 异步处理请求

性能表现强势

@platformatic/python-node 的基准测试聚焦于在 Node.js 进程内运行 Python ASGI 应用的性能表现。测试结果显示,该库在吞吐量和延迟方面表现出色,优于多个原生 Python ASGI 服务器。吞吐量5,200 req/sec(请求/秒),优于 fastapi run、daphne 和 hypercorn 等原生 Python 服务器。延迟低于 2ms(亚 2 毫秒),通过进程内嵌入和直接内存共享实现零网络开销。这一性能提升使 ML 推理速度提高了约 10 倍,数据管道处理同样受益。该基准强调了无序列化和无 socket 的设计优势,适用于 AI/ML 与 Node.js 混合应用场景。

应用:AI 推理服务集成

想象一个基于 React 的前端应用,需要实时调用 Python ML 模型进行图像识别。你可以使用 @platformatic/python-node 在 Node.js 后端嵌入 FastAPI 服务。

实战代码片段(扩展上例):

// 扩展 app.js 以处理文件上传

const multer = require('multer');

const upload = multer();

// 堆代码 duidaima.com

server.post('/predict', upload.single('image'), async (req, res) => {

const imageData = req.file.buffer; // 从前端上传的图像

const prediction = await asgiApp.call('predict', { image: imageData }); // 调用 Python 端预测函数

res.json(prediction);

});

Python 侧(添加 ML 路由,使用如 PyTorch):

from fastapi import UploadFile, File

import torch # 假设已安装 ML 库

@app.post("/predict")

async def predict(image: UploadFile = File(...)):

data = await image.read()

# 模拟 ML 推理

model = torch.hub.load('pytorch/vision:v0.10.0', 'resnet18', pretrained=True)

# ... 处理数据并返回结果

return {"prediction": "cat"}

运行方式:node app.js,然后从浏览器或 Postman 测试 /predict。

总结

@platformatic/python-node 为核心前端开发者提供了强大工具,将 Node.js 与 Python ASGI 无缝融合,提升了应用效率和扩展性。它不仅解决了语言壁垒,还为 AI 驱动的前端项目注入了新活力。

@platformatic/python-node 的发布标志着跨语言运行时的兴起,未来可能扩展到支持更多 Python 框架或甚至其他语言如 Julia。潜在影响包括简化微服务架构,让前端开发者更容易融入后端 AI 功能,推动 Serverless 和 Edge 计算的混合开发。前端大有可为!

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号