- 联系我们

- duidaima.com 版权声明

- 闽ICP备2020021581号

-

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

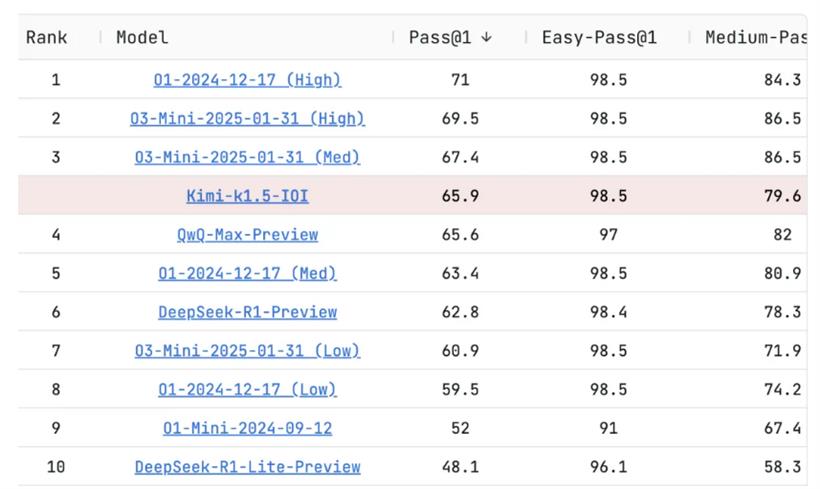

今天凌晨五点,阿里巴巴发布了发布了基于 Qwen2.5-Max 的推理模型QwQ-Max-Preview。从名字你能看出来,这仅仅只是预览版本。阿里巴巴表示,很快,他们将发布 QwQ-Max 正式版本,而且会基于Apache 2.0 许可证,全面开源 QwQ-Max 和 Qwen2.5-Max。全面开源,这是阿里巴巴的新策略。过去,虽然阿里巴巴发布了Qwen 2.5-Max,但这一顶配的大模型版本并没有开源,而是放到了阿里云上商业化。现在,阿里巴巴像 DeepSeek 一样更彻底的公开了自己的最新进展。

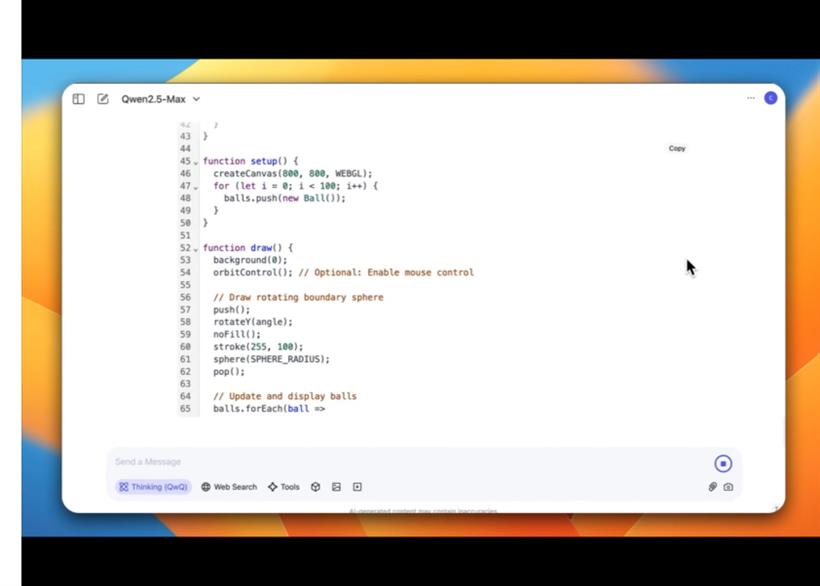

从界面看,Qwen 似乎正在做类似于 OpenAI CEO Sam Altman 之前描述的 GPT-5 要做的事情。一个模型将工具(网络搜索、图像生成、视频生成以及其他外部工具)和推理(QWQ)全部整合在了一起。官方发布了几个对应的使用场景,比如通过QWQ来生成代码。我测试了下,发现 QWQ 的思考速度非常快,生成的代码准确率非常之高。

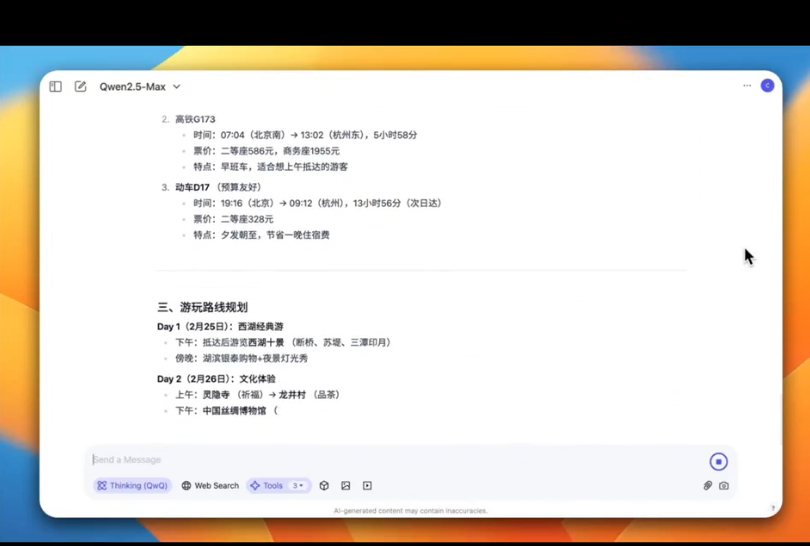

还可以使用它的Agent 功能:

实在太牛了。阿里巴巴,果然再一次,坚决的、迅猛的,站在了大模型的浪潮之中。就像我上周写的,阿里巴巴已经和拼多多不在一个层面竞争了,它早已成为一家硬科技公司。

上周四晚上,阿里开 2024 年第四季度业绩电话会议时,CEO 吴泳铭就说,春节期间,阿里看到推理需求激增,在新需求中约有 60% 到 70% 是推理需求,所以阿里很快会发布基于千问 Qwen2.5-MAX 的深度推理模型。

现在,这么快就兑现了。并且,更大的惊喜是全部开源。2 月 25 日,还没出蛇年的正月,大模型领域就如此精彩。就像昨晚一样,那头 Claude 发布 3.7,这头阿里巴巴开源最新的推理模型,一会 9 点多,DeepSeek 团队又会开源新的项目。波澜壮阔。