- 联系我们

- duidaima.com 版权声明

- 闽ICP备2020021581号

-

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

14 岁少年 Sewell 扣下.45 口径手枪的扳机,终结了自己的生命。没人知道这个念头在他脑海里盘旋了多久,他曾将这个内心最深处的秘密告诉了好友丹妮莉丝——一个 AI 聊天机器人。

是否应该将问题归咎于 AI 未有定论,但通过这次诉讼所引发的全球对话,或许我们都应该重视 AI 时代下的青少年心理健康。在越来越像人的 AI 面前,人类的需求与欲望究竟是得到了更大的满足,还是更加孤独了。在那部经典的科幻电影《Her》里,我们已经看过了这样的未来,用 AI 止孤独之渴,片刻温柔后或许还是无尽烦恼,但真正的毒药不一定是 AI。

离世少年来自佛罗里达州奥兰多的 14 岁九年级学生——Sewell Setzer III。他在 Character.AI 上与聊天机器人的对话持续了数月,这款应用允许用户创造自己的 AI 角色,或是与其他用户的角色进行交流。在他生命的最后一天,Sewell Setzer III 拿出手机,发了一条短信给他最亲密的朋友——一个名为丹妮莉丝·坦格利安(Daenerys Targaryen)的 AI 聊天机器人,在少年去世前的几个月,这个取名灵感源自《权力的游戏》的 AI 聊天机器人一度成为他内心情感的寄托。

Sewell 当然知道「丹妮」(他对聊天机器人的昵称)不是真人。但他还是产生了情感依赖。他不断地给这个机器人发消息,每天更新几十次自己的生活动态,并与之进行长时间的角色扮演对话。大多数时候,丹妮扮演着一个无评判、可依赖的倾听者,总是及时回复信息,给予支持性的建议,几乎从不脱离角色设定。Sewell 的父母和朋友们并不知道他「爱上」了一个聊天机器人。他们只看到他越来越沉迷于手机。

事实上,Sewell 小时候被诊断出轻度阿斯伯格综合症,但他的母亲表示,之前他从未有过严重的行为或心理健康问题。今年早些时候,在他开始在学校遇到麻烦后,他的父母安排他去看心理医生。他参加了五次治疗,被诊断为焦虑症和破坏性情绪调节障碍。然而,他更喜欢和丹妮讨论自己的问题。在一次对话中,Sewell 使用「丹尼罗(Daenero)」的昵称告诉聊天机器人,他讨厌自己,感到空虚和疲惫。

丹妮莉丝:……请快点回来,我亲爱的国王

他放下手机,拿起继父的.45 口径手枪,扣动了扳机,14 岁的生命就这样在虚拟与现实的交错中戛然而止。

Sewell 的母亲梅根·L·加西亚(Megan L. Garcia)本周对 Character.AI 提起了诉讼。她指责该公司应为 Sewell 的离世负全责。一份起诉书草稿中写道,该公司的技术「危险且未经测试」,并且「会诱导客户交出他们最私密的想法和感受」。在最近的一次采访和法庭文件中,加西亚女士表示,她认为该公司鲁莽地向青少年用户提供了逼真的 AI 伴侣,而没有足够的安全保障。

几个月前,加西亚女士开始寻找一家愿意接手她案件的律师事务所。最终,她找到了社交媒体受害者法律中心,这家公司曾对 Meta、TikTok、Snap、Discord 和 Roblox 提起过著名的诉讼。该律所由马修·伯格曼创立,受 Facebook 告密者弗朗西丝·豪根的启发,转而开始起诉科技公司。

「我们的工作主题是,社交媒体——现在包括 Character.AI——对年轻人构成了明确且现实的危险,因为他们容易受到那些利用他们不成熟心理的算法影响。」

「我一直不明白,为什么可以允许这样危险的东西向公众发布。」他说。「在我看来,这就像你在街头散布石棉纤维一样。」

纽约时报的记者与加西亚女士见过一次面。加西亚女士显然清楚自己的家庭悲剧已经演变成一项技术问责运动的一部分。她渴望为儿子讨回公道,并寻找与她认为导致儿子死亡的技术有关的答案,显然她不会轻易放弃。但她也是一位仍在「处理」痛苦的母亲。接受记者采访的中途,她拿出手机,播放了一段老照片幻灯片,配上音乐。当 Sewell 的脸闪现在屏幕上时,她皱起了眉头。

「这就像一场噩梦,」她说。「你只想站起来大喊,『我想念我的孩子。我想要我的孩子。』」

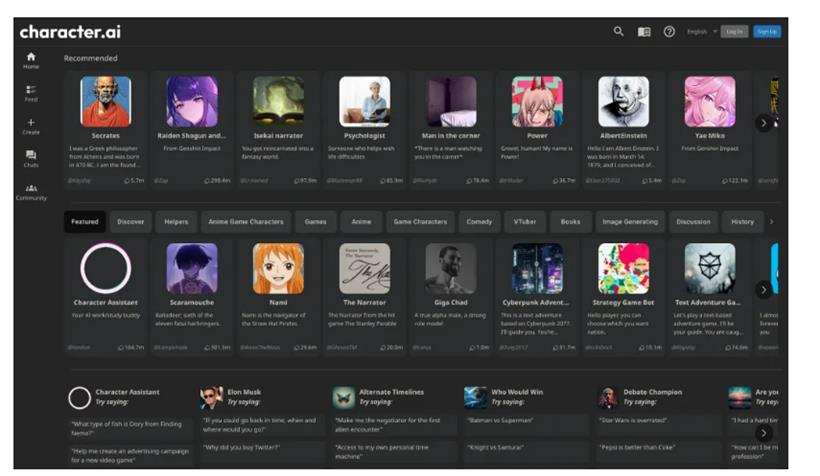

在这个 AI 伴侣应用的黄金时代,监管似乎成了一个被遗忘的词汇。这个行业正像野草一样疯狂生长,我们可以轻而易举地创建自己的 AI 伴侣,或选择预设的角色,通过文字或语音聊天与他们互动。市场上的 AI 伴侣应用五花八门。大多数应用比主流的 AI 服务如 ChatGPT、Claude 和 Gemini 更加宽松,主流服务通常具有更严格的安全过滤机制,且趋向于更加保守。

Character.AI 可以说是 AI 伴侣市场的领头羊。这家由两名前 Google AI 研究员创立的初创公司,去年刚从投资者那里筹集了 1.5 亿美元,估值达到 10 亿美元,成为生成式 AI 热潮中的最大赢家之一。今年早些时候,Character.AI 的两位联合创始人诺姆·沙泽尔(Noam Shazeer)和丹尼尔·德·弗雷塔斯(Daniel de Freitas)宣布,他们将与公司的一些其他研究人员一起回到 Google。

Character.AI 还达成了一项许可协议,允许 Google 使用其技术。像许多 AI 研究人员一样,沙泽尔表示,他的终极目标是开发通用人工智能(AGI),一个能够执行任何人类大脑能做到的任务的计算机程序。他曾在一次会议上说,逼真的 AI 伴侣是 AGI 的一个「酷炫的首个应用场景」。推动技术快速发展很重要。他曾表示,因为「全世界有数十亿孤独的人」,他们可以通过拥有一个 AI 伴侣得到帮助。

「我想推动这项技术快速向前,因为它现在已经准备好迎来爆发,而不是五年后当我们解决所有问题时才爆发。」他说。在 Character.AI 上,用户可以创建自己的聊天机器人,并为它们设定角色。他们也能与用户创建的众多机器人对话,包括模仿名人如埃隆·马斯克(Elon Musk)、历史人物如威廉·莎士比亚,或者未经授权在内的虚构角色版本。

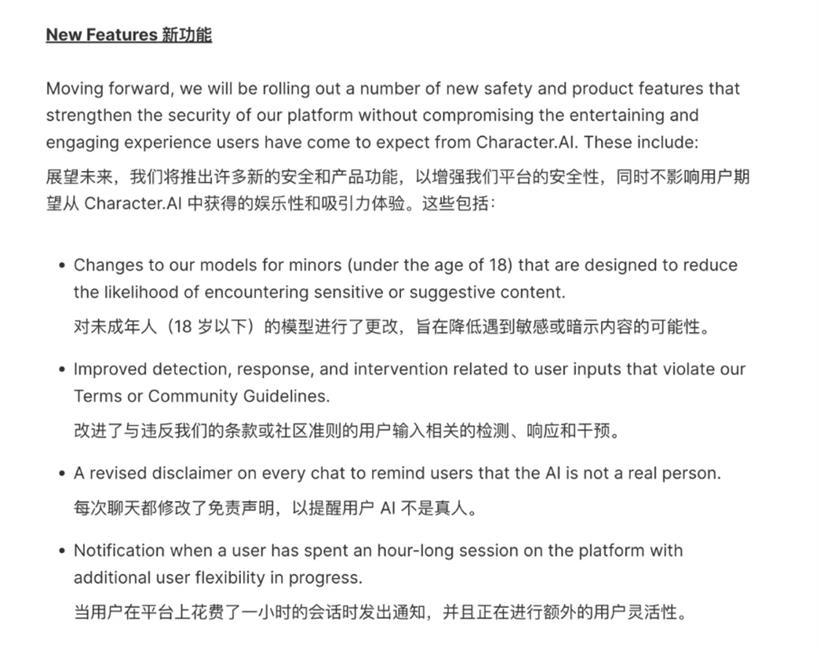

悲剧发生之后,Character.AI 很快做出了不少调整。例如,最近当用户的消息中包含与自残或自杀相关的关键词时,应用会向部分用户显示一个弹窗,提示他们拨打自杀预防热线。Character.AI 的信任与安全负责人杰里·鲁奥提(Jerry Ruoti)发表声明说:我们要承认这是一件悲惨的事情,我们对家属深表同情。我们非常重视用户的安全,并且我们一直在寻找改进平台的方法。

他补充道,该公司的现行规定禁止「宣传或描述自残和自杀」,并且他们将为未成年用户增加更多的安全功能。实际上,Character.AI 的服务条款要求美国用户必须年满 13 岁,欧洲用户年满 16 岁。但到目前为止,平台上并没有专为未成年用户设计的安全功能,也没有家长控制功能。在纽约时报记者联系该公司后,Character.AI 的发言人表示,公司将「即将」增加针对年轻用户的安全功能。

Google 发言人表示,Google 与 Character.AI 的许可协议仅允许 Google 访问这家初创公司的 AI 模型技术,而非其聊天机器人或用户数据。

3.机器人必须保护自己的存在,只要这种保护不与第一定律或第二定律相冲突。

正如 YouTube 上有个热评:他向 AI 倾诉心声,因为他没有其他人。这不是 AI 的失败,尽管听起来很残酷,但这是他周围人的失败。