斯坦福大学的李飞飞教授,又带着她的新成果来“砸场子”了。只用一张图,甚至一句话,就能直接生成一个可以让你在里面“逛街”的3D世界。不是图片,也不是视频,而是一个活生生的、可以自由探索、永久存在的3D虚拟空间。这让还在2D图像和视频生成领域“内卷”的同行们,感受到了来自学术界顶流的“物理暴击”。标志着生成式AI已经悄然完成了从“画画”到“盖楼”的进化,从一个二维平面画师,进化成了一个三维空间造物主。World Labs在他们官方博客说,“We are building Large World Models to perceive, generate, and interact with the 3D world.”(我们正在构建大型世界模型,让AI能够感知、生成并与3D世界交互)。

李飞飞团队是如何把它从科幻电影里搬进现实的?它背后的技术有多硬核?又将如何掀翻游戏、电影、元宇宙这些行业的桌子?

从ImageNet到世界模型,李飞飞的“三界”野望

十几年前,那个梦开始的地方,李飞飞一手缔造了AI“龙兴之地”——ImageNet。在那个深度学习还只是少数几位学者脑中火花的年代,是李飞飞顶着巨大的压力和质疑,主导创建了这个拥有超过1400万张标注图像的庞大数据集。正是这个“军火库”,为后来深度学习模型的训练提供了充足的“弹药”,直接点燃了现代AI革命的导火索。毫不夸张地说,李飞飞用ImageNet,为机器打开了“看懂”二维世界的大门,是名副其实的AI视觉智能奠基人。

对于李飞飞这样的顶尖科学家来说,让机器“看懂”世界,仅仅是万里长征的第一步。她的目光,早已越过了屏幕上的2D像素点,投向了我们所生存的、更加复杂、更加真实的三维物理世界。在多个公开场合,一个观点被她反复提及,并被多家权威媒体广泛引用:“Spatial intelligence is the next frontier in AI”(空间智能是AI的下一个前沿)。

意思就是,AI的下一站,不是写诗更溜,也不是画画更像,而是要真正理解我们这个三维空间,能在里面进行推理、互动,甚至创造。这已经不是简单的“看”,而是要进阶到“理解”和“行动”的层面了。

恰逢其时,“世界模型”(world model)开始在AI研究的前沿阵地崭露头角。世界模型的目标,就是教AI在自己的“脑子”里,构建一个能够模拟现实世界运行规律的虚拟空间。这个模型不仅要知道“桌子上有一个苹果”,还要知道“苹果从桌子上掉下来会往下落,而不是往上飞”,它要理解物理法则、时间序列和因果关系。这和我们熟悉的2D图像模型,有着本质的区别。后者更像是一个才华横溢的画家,你说啥它画啥,但画出来的东西是静止的、平面的。而世界模型,则更像是一个“造物主”,它要创造的是一个动态的、可交互的、符合物理逻辑的“小宇宙”。

科技巨头们也纷纷下场,试图抢占这个未来高地。比如,谷歌就搞出了一个叫Genie的模型,Decart公司也有一个叫Oasis的项目。但它们生成的场景,普遍存在一个致命缺陷——“健忘症”。就像《初恋50次》的男主角,每天醒来都失忆,这些模型生成的场景,你稍微挪动一下视角,它可能就忘了刚才背后是啥样了,导致几何结构前后矛盾,物体忽有忽无。交互性也差得可怜。

而李飞飞团队Marble要做的,是一个不仅“记得住”,而且“随便逛”,还能“动手改”的真正世界模型。

揭秘Marble:把科幻照进现实的“魔法”

根据World Labs官方博客的“产品说明书”,Marble平台的看家本领,就是把一张静态的图片或者一段描述性的文字,像变魔术一样,变成一个完整的、可供探索的3D世界。

首先是“持久存在”。这一点至关重要,也是它吊打一众前辈的核心优势。传统的视频生成模型,本质上是一帧一帧地“猜”,所以经常出现前后帧物体不一致的“穿帮镜头”。而Marble生成的3D场景,一旦构建完成,就拥有了“肌肉记忆”,它是一个完整的几何实体,无论你的视线怎么移动,甚至绕到物体的背后,场景都会保持其固有的结构,不会凭空消失或变形。这种“所见即所得,所不见亦存在”的特性,才是一个真正虚拟世界该有的样子。

第二是“可自由导航”。用户不再是被动地观看一段预设好的视频,而是可以像玩第一人称游戏一样,用键盘和鼠标,在浏览器里实时操控自己的视角,上天入地,穿梭于场景的每一个角落。你可以凑近一朵花,看清它的纹理;也可以飞到屋顶,俯瞰整个庭院的全貌。它甚至能“脑补”出你上传的那张图片里没有拍到的部分,让你真正有一种“身临其境”的探索感。

第三是“可自定义操控”。Marble提供的不仅仅是一个静态的“毛坯房”,还给用户提供了一套“精装修”工具。你可以像摄影师一样,实时调整景深(DoF),营造出电影般的虚化效果;也可以像室内设计师一样,随心所欲地改变场景中物体的颜色;甚至还能扮演“灯光师”,调整动态光照,观察光影在不同角度下的变化。这种高度的交互性,让创作的自由度大大提升。

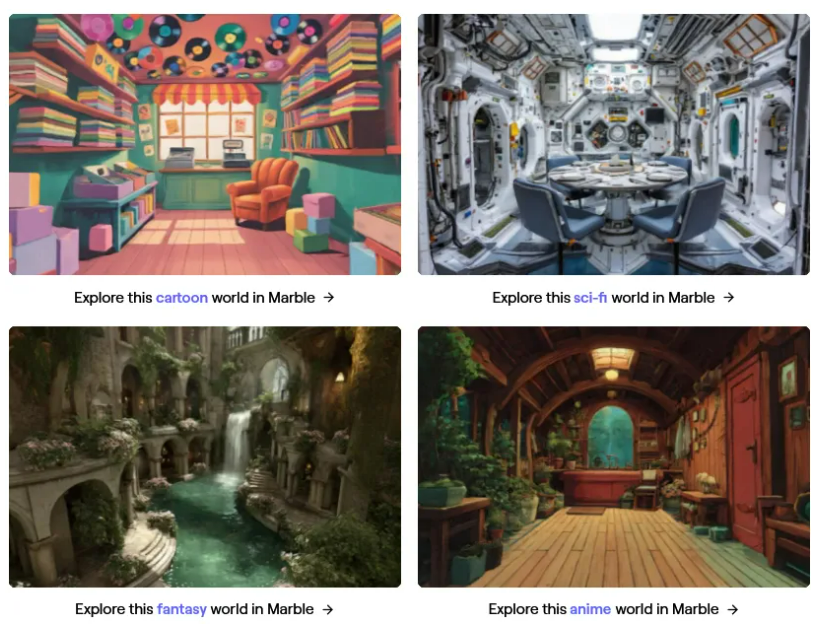

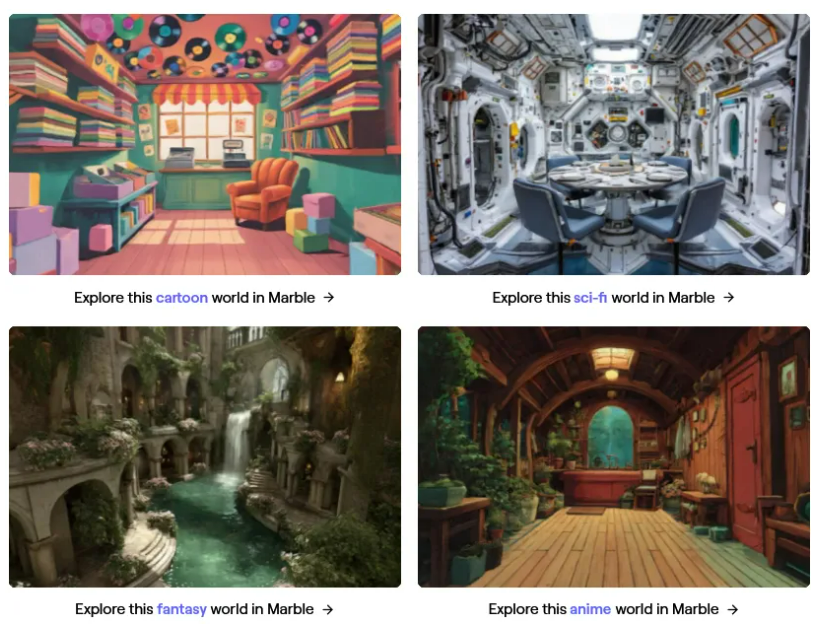

不仅如此,Marble还是个“风格大师”。无论你想要的是色彩明快的卡通风,还是细节逼真的写实风,抑或是光怪陆离的赛博朋克风,它都能精准拿捏,生成高质量的场景。更厉害的是,它还支持“场景拼接”功能。这意味着你可以先生成一个森林,再生成一个城堡,然后把它们无缝地拼接在一起,理论上可以构建出一个无限大的虚拟世界。这想象空间,可就太大了。

如此神奇的效果,背后到底藏着什么样的“黑科技”呢?虽然World Labs本着“商业机密”的原则,没有把完整的技术论文公之于众,但通过官方的只言片语和其“豪华”的创始团队背景,我们还是能顺藤摸瓜,窥探一二。业界普遍推断,其技术路线与近年来在图形学领域大放异彩的“3D高斯点云”(3D Gaussian Splatting, 3DGS)技术紧密相关。

3DGS,你可以把它想象成一种全新的、更高级的3D建模方式。传统的3D建模,要么是用无数个三角面片(多边形网格)去拼凑,要么是用体素(像乐高积木一样的小方块)去搭建。而3DGS,则是用海量的、带有颜色、透明度、大小和方向的“高斯椭球体”来描绘整个场景。这种方法的牛X之处在于,它既能像照片一样真实地还原光影和细节,又能像3D模型一样被高速渲染出来,实现了“鱼和熊掌兼得”。

World Labs的联合创始人之一Ben Mildenhall,恰好就是另一项革命性3D渲染技术NeRF(神经辐射场)的联合发明人,而NeRF正是3DGS的重要技术前身。这层关系,基本上算是“官方剧透”了。

Marble的整个工作流程,我们大概可以脑补为这样三步曲:

第一步,“输入处理”。当你给它一张图片或一段文字时,它会先用一个强大的AI模型去解析这里面包含了哪些物体、它们大概是什么样的空间关系,把非结构化的信息给“吃透”。

第二步,“3D重建”。接下来,它会调用类似3DGS的看家本领,在虚拟空间中“喷洒”出亿万个高斯小球,把脑海中理解的场景给精准地“画”出来,构建出一个具有真实几何结构的3D空间。

第三步,“实时渲染”。最后,通过一个名为Spark的开源渲染库,将这个由无数高斯小球构成的复杂场景,以极高的效率渲染出来。

Marble的实测表现

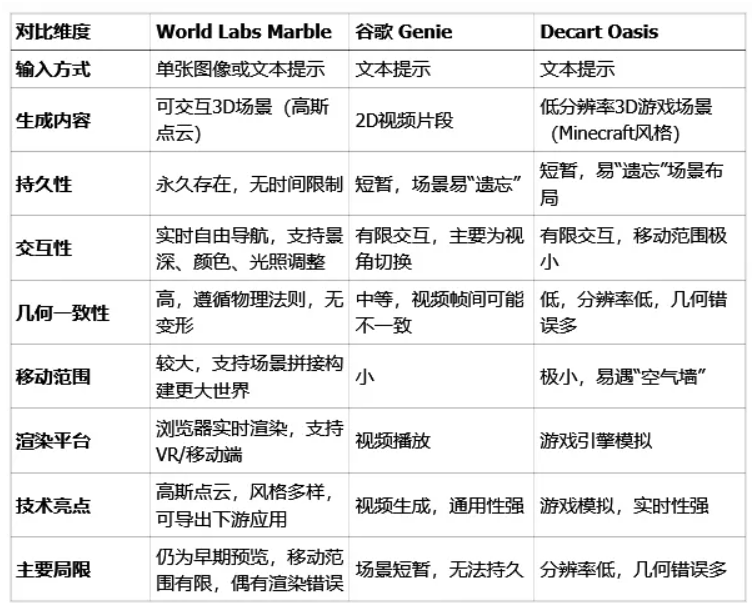

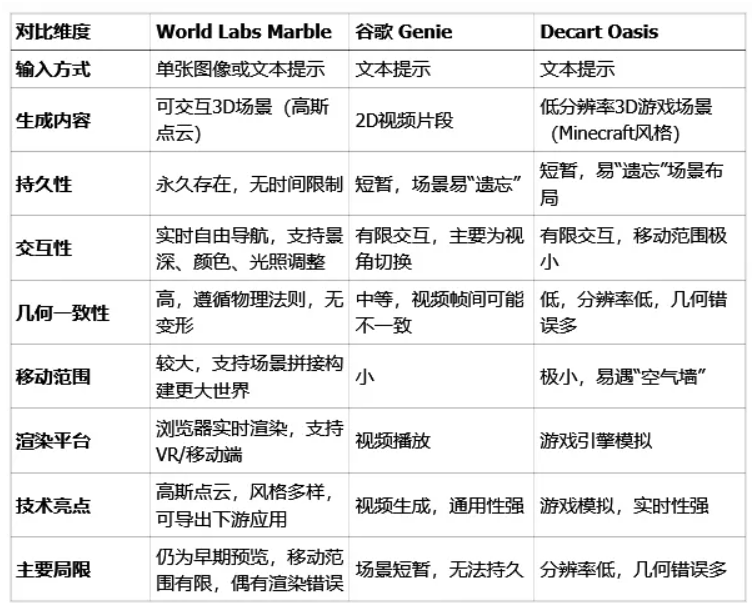

我们把它和目前最具代表性的两位“前辈”——谷歌的Genie和Decart的Oasis,拉到同一个擂台上。下面的对比数据,是综合了World Labs官方博客、MIT Technology Review、TechCrunch等多个权威信源的信息。

从最核心的几个维度来看,Marble几乎是全方位的领先。在“持久性”上,Marble的“永久存在”特性,直接解决了Genie和Oasis最大的痛点——“健忘症”。这意味着Marble生成的场景是可靠的、可复用的,可以作为数字资产被保存和编辑,而Genie和Oasis生成的更像是一次性的“烟花”。

在“交互性”和“几何一致性”上,Marble更是展现出了“代差”级别的优势。它提供的实时自由导航和丰富的自定义功能,让用户真正拥有了对这个虚拟世界的主宰感。而其基于3D几何重建的技术,保证了场景的物理真实性,不会出现“墙壁突然消失”或者“桌子腿长短不一”的诡异情况。相比之下,Genie的交互还停留在简单的视角切换,视频帧之间还可能出现不连贯的bug。Oasis虽然生成的是3D场景,但分辨率低得感人,像是打了厚码的Minecraft,几何错误更是家常便饭。

在“移动范围”和“应用潜力”上,Marble支持场景拼接,理论上可以构建无限大的世界,并且可以将生成的3D高斯点云导出,用于游戏引擎、影视制作等专业领域。

当然,Genie和Oasis也有其自身的特点。Genie的强项在于其视频生成的通用性,它能生成各种天马行空的2D小游戏视频。Oasis则在游戏模拟的实时性上做了很多探索。

一个价值10亿美金的“小目标”

World Labs公司的背景,可以说是“豪华”到令人咋舌。根据路透社等权威媒体的报道,World Labs的正式成立时间是在2024年9月13日。这是一个非常新的公司,但其创始团队,却是一群在AI领域摸爬滚打了多年的“老江湖”。领军人物自然是李飞飞,她的学术地位和行业影响力无需赘述。联合创始人Justin Johnson,同样是圈内大神,他曾是Meta的资深研究科学家,也是斯坦福大学最火的AI课程CS231n的联合创始人之一,无数AI从业者都是看着他的课入门的。另外两位联合创始人,Christoph Lassner曾在Meta和Epic Games(《堡垒之夜》的开发商)任职,是图形学和3D领域的专家;Ben Mildenhall则是NeRF的联合发明人,手握3D渲染的“屠龙之技”。

公司一亮相,就宣布完成了高达2.3亿美元的风险投资。领投的是硅谷顶级风投A16z,跟投的包括芯片巨头Intel Capital和AMD Ventures。此外,个人投资者名单里,更是闪耀着一串如雷贯耳的名字:前谷歌CEO埃里克·施密特(Eric Schmidt),谷歌AI负责人杰夫·迪恩(Jeff Dean),以及被誉为“深度学习之父”的杰弗里·辛顿(Geoffrey Hinton)。

根据TechCrunch的报道,公司的估值已经超过了10亿美元,成功跻身“独角兽”俱乐部。从成立到成为独角兽,World Labs只用了极短的时间,这背后,是资本市场对“3D世界生成”这一赛道价值的最高认可。

李飞飞本人,也通过各种渠道,不断地向外界传递着她对“空间智能”的深刻思考。她认为,当前火热的大语言模型,虽然在处理文本方面表现出了惊人的能力,但它们就像一个被困在“小黑屋”里的博学智者,对物理世界一无所知,这限制了它们通往通用人工智能(AGI)的道路。AI要想真正地“智能”,就必须走出这个“小黑屋”,去理解和感知三维空间。

她在自己的社交媒体上,用一段极具诗意和前瞻性的话,描绘了她心中的蓝图:“For all of history, humanity shared one 3D world. Spatial intelligence now lets us generate and reconstruct infinite universes for creativity, travel, narrative, and even social.”(纵观历史,人类共享一个3D世界。空间智能现在让我们能够生成并重建无限的宇宙,用于创造、旅行、叙事,甚至社交。)

联合创始人Justin Johnson则从更实际的产业角度,阐述了他们正在做的事情的价值。据媒体报道,他指出,在电影、游戏这些行业,传统3D内容的创作是一个极其“烧钱”且“耗时”的工程,一个3A大作或者一部好莱坞特效大片,动辄投入数亿美元和数年的开发周期,是名副其实的“重工业”。而World Labs的目标,就是要把这个“重工业”,变成人人都能上手的“轻工业”。

“我们的世界模型技术,将让创作者不再只是得到一张图片或一段视频,而是获得一个完全模拟、充满活力、可交互的3D世界。这会彻底改变电影、游戏、模拟器等数字内容的制作方式。”

3D世界生成,已经不仅仅是一个技术概念,而是正在迅速成为AI领域的下一个超级风口。

参考资料:

https://www.worldlabs.ai/blog/bigger-better-worlds

https://www.worldlabs.ai/

https://marble.worldlabs.ai/

https://profiles.stanford.edu/fei-fei-li

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号

闽公网安备 35020302035485号